Navigation

Qui se souvient de l’émission Mes Mains ont la parole (1979-1988) sur feu Antenne 2 ? Marie-Thérèse Abbou y traduisait tendrement des contes pour enfants en langue des signes. Signbot et son petit air de théâtre de marionnettes pourrait bien être son équivalent automate. Sauf que le proto conçu au cours du McHacks, un hackathon organisé les 28 et 29 janvier à l’université québécoise McGill, n’a pas encore la dextérité de l’animatrice. Il faut dire que Signbot a été réalisé en seulement 24 heures par quatre étudiants en informatique : Alex Foley, Clive Chan, Wilson Wu et Colin Daly, tous de l’université de Waterloo en Ontario.

Signbot, démo finale :

Du geste à la parole

Dans un premier temps, Signbot repose sur la téléprésence des mains, un classique de la robotique qui consiste à faire mimer les gestes de l’opérateur par une machine. A l’aide d’une Kinect ou dans ce cas d’un capteur Leap Motion, associé à deux mains mécanisées. Mais à ce stade, encore fallait-il connaître la langue des signes. Les étudiants ont constitué une petite bibliothèque de signes ASL - la version américaine de la langue des signes - et développé une reconnaissance vocale. Devant le jury, une main du Signbot a su faire le « Hello » qu’on venait de lui souffler. Un POC (Proof of concept) et une victoire à la clé.

Deux mains gauches

Pour parvenir à leurs fins, les quatre étudiants ont dû jongler avec de nombreuses disciplines. Le projet déposé sur Github a fait l’objet de rapports sur Devpost et Hackaday mais c’est sur Medium qu’Alex Foley a raconté leurs défis par le menu. En préambule, les mains et leurs quatorze servomoteurs, des filins en nylon... et une erreur qui a failli leur coûter la victoire : Clive Chan, chargé d’imprimer les phalanges, a sorti deux mains gauches ! La main droite a vu le jour in extremis, un peu plus fragile. Alex Foley a dû ensuite se battre avec la plateforme logicielle Node.JS pour transmettre les mouvements de l’API Leap Motion aux servomoteurs, et s’est rendu compte presque en bout de course que les deux Arduino Mega ne prenaient pas en charge le bon compte de servomoteurs.

Signbot et l’API Leap Motion, démo :

Les concepteurs sont plutôt fiers d’avoir surmonté les difficultés de la synthèse vocale grâce au kit de développement (devkit) de reconnaissance vocale Nuance, qu’ils ont découvert à l’occasion, et manipulé avec tout un tas de calculs trigonométriques pour le traitement du son. Lors de la présentation au jury, l’introduction empruntée à la Fédération mondiale des sourds a su convaincre le jury de l’intérêt de Signbot : « La langue des signes est la première langue pour 70 millions de personnes. » Qu’en auraient pensé les principaux intéressés ?

Une signothèque qui aura manqué

Nous avons contacté Sj Rideaf, inlassable acteur toulousain du rapprochement entre sourds et entendants et militant de l’accessibilité dans les fablabs. Il s’est gardé de se prononcer sur la portée du proto, mais a rappelé l’intérêt de sa Signothèque, prix d’innovation sociale 2016, qui compile en open source la langue des signes (LS) sous forme de vecteurs numériques. Les étudiants de l’université Waterloo ont confirmé que cette bibliothèque leur aurait été fort utile s’ils en avaient eu connaissance. Ils reconnaissent aussi qu’il faudrait miniaturiser le concept pour un usage domestique et bien sûr augmenter le vocabulaire de l’animatronique.

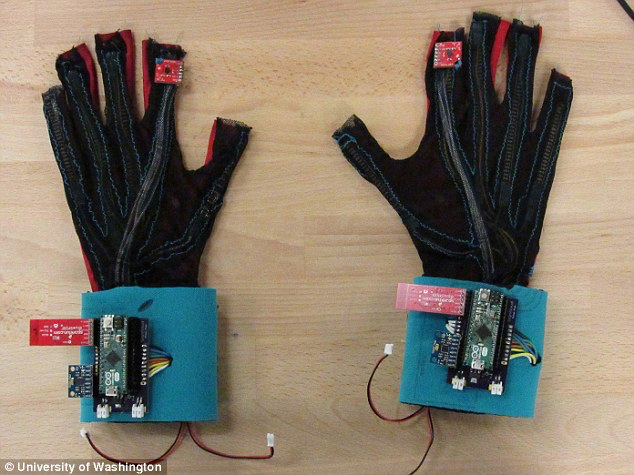

A l’ère du tout capteur, Signbot n’est pas le seul proto sur le créneau de la langue des signes. En avril 2016, deux étudiants de l’université de Washington ont également remporté un prix avec le concept inverse, Signaloud ; en l’occurrence des signes à la parole, grâce à des gants équipés de capteurs. En 2014, Motion Savvy conçevait Uni, une application qui marche sur les plates-bandes de Signbot avec sa traduction bidirectionnelle sur tablette.

L’application Uni de Motion Savvy, démo (2014) :

Les étudiants makers de Signbot n’ont pas encore été contactés par des associations de sourds. Leur proto reste une excellente performance hackathonnienne. Pourrait-il avoir un avenir si on l’implémentait dans un robot qui voudrait s’adresser aux 70 millions d’interlocuteurs sourds et malentendants ? Pour les étudiants, « ça demanderait énormément de travail mais ce serait vraiment cool de voir ça. » Une fonction qui plairait sûrement à C-3PO, le robot traducteur pas très dégourdi de Star Wars.

Le Github de Signbot